Pentagon chce nasadit zbraně s umělou inteligencí, které nás ohrozí

Nedávné drama v představenstvu společnosti OpenAI – technologického startupu se sídlem v San Francisku, který stojí za nesmírně populárním počítačovým programem ChatGPT – bylo popsáno jako boj o moc ve firmě, střet osobností motivovaný egem a strategický spor o uvolnění schopnějších variant ChatGPT. (Foto: X)

Bylo to všechno a ještě víc, ale v jádru šlo o neobvykle ostrý boj mezi těmi představiteli společnosti, kteří podporují neomezený výzkum pokročilých forem umělé inteligence (AI), a těmi, kteří se v obavách z možných katastrofických důsledků takového úsilí snaží zpomalit tempo vývoje AI.

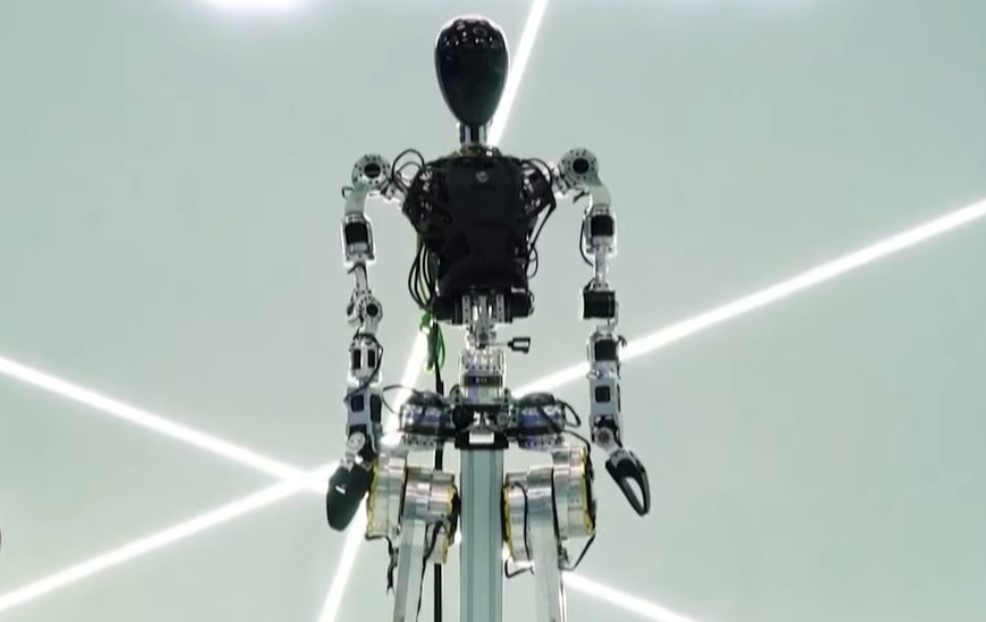

Přibližně ve stejné době, kdy se tato epochální bitva rozbíhala, se na půdě OSN v New Yorku a na vládních úřadech ve Washingtonu odehrával podobný boj o vývoj autonomních zbraňových systémů – bezpilotních lodí, letadel a tanků řízených umělou inteligencí namísto lidí. V tomto souboji se široká koalice diplomatů a aktivistů za lidská práva snažila prosadit právně závazný zákaz těchto zařízení, odpůrci nazývaných „roboty zabijáky“, zatímco úředníci ministerstev zahraničí a obrany prosazovali jejich rychlý rozvoj.

V obou skupinách sporů jde o soupeřící názory na důvěryhodnost pokročilých forem umělé inteligence, zejména „velkých jazykových modelů“ používaných v systémech „generativní umělé inteligence“, jako je ChatGPT. (Programy jako tyto se nazývají „generativní“, protože dokáží vytvořit text nebo obrázek v lidské kvalitě na základě statistické analýzy dat získaných z internetu). Zastánci vývoje a použití pokročilé umělé inteligence – ať už v soukromém sektoru, nebo v armádě – tvrdí, že takové systémy lze vyvíjet bezpečně; ti, kteří před takovou činností varují, říkají, že to nejde, alespoň ne bez podstatných bezpečnostních opatření.

Aniž bychom se pouštěli do podrobností dramatu kolem OpenAI, které prozatím skončilo 21. listopadu jmenováním nových členů správní rady a návratem Sama Altmana, který byl pět dní předtím propuštěn, do funkce výkonného ředitele, je zřejmé, že krizi vyvolaly obavy členů původní správní rady, že Altman a jeho zaměstnanci se navzdory slibům větší opatrnosti vydali příliš rychlým směrem vývoje umělé inteligence.

Altman a mnozí jeho kolegové se domnívají, že technici jsou na pokraji vytvoření „obecné umělé inteligence“ nebo „superinteligence“ – programů umělé inteligence, které jsou tak výkonné, že mohou duplikovat všechny aspekty lidského poznání a samy se naprogramovat, takže programování člověkem není nutné. Takové systémy prý budou schopny vyléčit většinu lidských nemocí a provádět další prospěšné zázraky – ale také, jak varují kritici, zlikvidují většinu lidských pracovních míst a nakonec se mohou rozhodnout člověka zcela odstranit.

„Z hlediska potenciálních kladů i záporů bude superinteligence mocnější než jiné technologie, s nimiž se lidstvo muselo potýkat v minulosti,“ napsal Altman a jeho vrchní poručíci v květnu. „Můžeme mít dramaticky blahobytnější budoucnost, ale abychom se k ní dostali, musíme zvládat rizika.“

Pro Altmana, stejně jako pro mnoho dalších lidí v oblasti umělé inteligence, má toto riziko „existenciální“ rozměr, který zahrnuje možný kolaps lidské civilizace – a v krajním případě i vyhynutí lidstva. „Myslím si, že pokud se tato technologie pokazí, může se to dost zvrtnout,“ řekl Altman 16. května na slyšení v Senátu. Altman rovněž podepsal otevřený dopis, který 30. května zveřejnilo Centrum pro bezpečnost umělé inteligence a v němž varuje před možným „rizikem vyhynutí v důsledku umělé inteligence“. Zmírnění tohoto rizika, jak dopis avizuje, „by mělo být globální prioritou vedle dalších rizik celospolečenského rozsahu, jako jsou pandemie a jaderná válka“.

Altman a další vrcholní představitelé AI nicméně věří, že superinteligence může a měla by být rozvíjena, pokud budou na cestě zavedena odpovídající bezpečnostní opatření. „Jsme přesvědčeni, že přínosy dosud nasazených nástrojů výrazně převažují nad riziky, ale zajištění jejich bezpečnosti je pro naši práci zásadní,“ řekl Altman senátnímu podvýboru pro soukromí, technologie a právo.

Washington prosazuje umělé inteligence ve válce

Podobným kalkulem ohledně využívání pokročilé umělé inteligence se řídí i pohled vysokých úředníků ministerstev zahraničí a obrany, kteří tvrdí, že umělá inteligence může a měla by být využívána k ovládání budoucích zbraňových systémů – pokud se tak bude dít „zodpovědným“ způsobem.

„Nemůžeme předvídat, jak se budou technologie umělé inteligence vyvíjet nebo čeho by mohly být schopny za rok nebo za pět let,“ prohlásila 13. listopadu na prezentaci v OSN velvyslankyně Bonnie Jenkinsová, náměstkyně ministra zahraničí pro kontrolu zbrojení a nešíření zbraní. Nicméně poznamenala, že Spojené státy jsou odhodlány „zavést nezbytné politiky a vybudovat technické kapacity, které umožní odpovědný rozvoj a využívání [umělé inteligence armádou] bez ohledu na technologický pokrok“.

Jenkinsová byla toho dne v OSN, aby představila „Politickou deklaraci o odpovědném vojenském využívání umělé inteligence a autonomie“, která je výzvou inspirovanou Spojenými státy k dobrovolnému omezení vývoje a nasazení autonomních zbraní s umělou inteligencí. Deklarace mimo jiné avizuje, že „státy by měly zajistit, aby bezpečnost, zabezpečení a účinnost vojenských schopností umělé inteligence podléhaly vhodnému a přísnému testování“ a že „státy by měly zavést vhodná ochranná opatření ke zmírnění rizik selhání vojenských schopností umělé inteligence, jako je například možnost … deaktivovat nasazené systémy, pokud tyto systémy vykazují nezamýšlené chování“.

Nic z toho však nepředstavuje právně závazný závazek států, které deklaraci podepíší; jde spíše jen o slib dodržovat soubor osvědčených postupů bez požadavku prokázat dodržování těchto opatření nebo rizika trestu v případě zjištění jejich nedodržování.

Ačkoli deklaraci podepsalo několik desítek zemí – většinou blízkých spojenců Spojených států -, mnoho dalších států, včetně Rakouska, Brazílie, Chile, Mexika, Nového Zélandu a Španělska, trvá na tom, že dobrovolné dodržování souboru standardů navržených Spojenými státy není dostatečné k ochraně před nebezpečím, které představuje nasazení zbraní s umělou inteligencí. Místo toho usilují o právně závazný nástroj, který by stanovil přísná omezení používání takových systémů nebo je zcela zakázal. Pro tyto aktéry je riziko, že se takové zbraně „zkazí“ a povedou neoprávněné útoky na civilní obyvatelstvo, jednoduše příliš velké na to, aby bylo možné povolit jejich použití v boji.

„Lidstvo se chystá překročit zásadní práh hlubokého významu, kdy o životě a smrti již nebudou rozhodovat lidé, ale bude se rozhodovat na základě předem naprogramovaných algoritmů. To vyvolává zásadní etické otázky,“ řekl deníku The Nation velvyslanec Alexander Kmentt, hlavní rakouský vyjednavač pro odzbrojení, kontrolu zbrojení a nešíření zbraní.

Rakousko a řada latinskoamerických zemí se již léta snaží prosadit zákaz těchto zbraní pod záštitou Úmluvy o některých konvenčních zbraních (CCW), smlouvy OSN z roku 1980, jejímž cílem je omezit nebo zakázat zbraně, o nichž se má za to, že způsobují zbytečné utrpení bojovníkům nebo nevybíravě zasahují civilisty. Tyto země spolu s Mezinárodním výborem Červeného kříže a dalšími nevládními organizacemi tvrdí, že plně autonomní zbraně spadají do této kategorie, neboť se ukáže, že v zápalu boje nebudou schopny rozlišovat mezi bojovníky a civilisty, jak to vyžaduje mezinárodní právo. Ačkoli se zdá, že většina smluvních stran CCW sdílí tento názor a je pro přísnou kontrolu autonomních zbraní, rozhodnutí signatářských států se přijímají konsensem a hrstka zemí, včetně Izraele, Ruska a Spojených států, využila svého práva veta, aby přijetí jakéhokoli takového opatření zablokovala. To zase vedlo zastánce regulace k tomu, aby se obrátili na Valné shromáždění OSN – kde se rozhodnutí přijímají většinou hlasů, nikoliv konsensem – jako na arénu pro budoucí pokrok v této otázce.

Dne 12. října se první výbor Valného shromáždění, odpovědný za mír, mezinárodní bezpečnost a odzbrojení, vůbec poprvé zabýval nebezpečím, které představují autonomní zbraně, a velkou většinou hlasů – 164 ku 5 (8 se zdrželo hlasování) – pověřil generálního tajemníka, aby provedl komplexní studii o této otázce. Studie, která má být dokončena do příštího zasedání Valného shromáždění (na podzim 2024), má prozkoumat „výzvy a obavy“, které takové zbraně vyvolávají „z humanitárního, právního, bezpečnostního, technologického a etického hlediska a z hlediska úlohy člověka při použití síly“.

Ačkoli opatření OSN neukládá žádná závazná omezení pro vývoj nebo používání autonomních zbraňových systémů, vytváří základ pro budoucí přijetí takových opatření tím, že identifikuje řadu obav z jejich nasazení a trvá na tom, aby generální tajemník při vypracování požadované zprávy tato nebezpečí podrobně prozkoumal, včetně toho, že si vyžádá názory a odborné poznatky vědců a organizací občanské společnosti.

„Cílem je samozřejmě pokročit v regulaci autonomních zbraňových systémů,“ naznačil velvyslanec Kmentt. „Z rezoluce jasně vyplývá, že drtivá většina států chce tuto otázku řešit s naléhavostí.“

Co se odehraje na zasedání Valného shromáždění příští rok, nelze předvídat, ale pokud má Kmentt pravdu, můžeme očekávat mnohem živější mezinárodní debatu o vhodnosti povolení nasazení zbraňových systémů s umělou inteligencí – ať už účastníci souhlasili s dobrovolnými opatřeními, která prosazují Spojené státy, nebo ne.

V Pentagonu se jede na plné obrátky

Pro představitele ministerstva obrany je však tato záležitost do značné míry vyřešena: Spojené státy budou pokračovat v rychlém vývoji a nasazení mnoha typů autonomních zbraňových systémů s umělou inteligencí. To bylo zřejmé 28. srpna, kdy náměstkyně ministra obrany Kathleen Hicksová oznámila iniciativu „Replikátor“.

S poukazem na to, že Spojené státy se musí připravit na možnou válku s čínskou armádou, Lidovou osvobozeneckou armádou (PLA), v nepříliš vzdálené budoucnosti a že americké síly se nemohou vyrovnat zásobám zbraní PLA v jednotlivých položkách (tank za tank, loď za loď atd.), Hicksová uvedla, že USA musí být připraveny překonat převahu Číny v konvenčních měřítkách síly – její vojenskou „hmotnost“ – nasazením „mnoha tisíců“ autonomních zbraní.

„Abychom si udrželi náskok, vytvoříme nový stav techniky – stejně jako předtím Amerika – s využitím atritabilních [tj. jednorázových], autonomních systémů ve všech oblastech,“ řekla manažerům firem na zasedání Národní asociace obranného průmyslu ve Washingtonu. „Proti masám PLA budeme bojovat vlastními masami, ale ty naše se budou hůře plánovat, hůře zasahovat a hůře porážet.“

V následném projevu, který Hicksová přednesla 6. září, poskytla (poněkud) podrobnější informace o tom, co nazvala autonomními zbraňovými systémy s možností zachycení všech oblastí (ADA2). „Představte si distribuované kapsle samohybných systémů ADA2 na hladině… plné senzorů….. Představte si flotily pozemních systémů ADA2, které poskytují novou logistickou podporu a provádějí průzkum dopředu, aby zajistily bezpečnost vojáků….. Představte si hejna [vzdušných] systémů ADA2, které létají v nejrůznějších výškách a plní celou řadu úkolů na základě toho, co jsme viděli na Ukrajině.“

V souladu s oficiálními pokyny Hicksová ujistila, že všechny tyto systémy „budou vyvíjeny a nasazovány v souladu s naším odpovědným a etickým přístupem k umělé inteligenci a autonomním systémům“. Ale kromě tohoto jednořádkového přitakání bezpečnosti byl veškerý důraz v jejích projevech kladen na rozbití byrokratických překážek s cílem urychlit vývoj a nasazení autonomních zbraní. „Pokud [tato úzká místa] nebudou vyřešena,“ prohlásila 28. srpna, „naše soukolí bude stále šrotovat příliš pomalu a naše inovační motory stále nebudou pracovat takovou rychlostí a v takovém rozsahu, jak potřebujeme. A s tím se nemůžeme smířit.“

A tak se mocní – jak v Silicon Valley, tak ve Washingtonu – rozhodli pokračovat ve vývoji a využívání ještě pokročilejších verzí umělé inteligence navzdory varováním vědců a diplomatů, že bezpečnost těchto programů nelze zajistit a že jejich zneužití může mít katastrofální následky. Pokud nebude vyvinuto větší úsilí o zpomalení těchto snah, můžeme zjistit, jaké důsledky by to mohlo mít.

Zdroj: thenation.com